分享币圈内容,享内容挖矿收益

placeholder

- 赞赏

- 1

- 1

- 转发

- 分享

Princess of Bitcoin  :

:

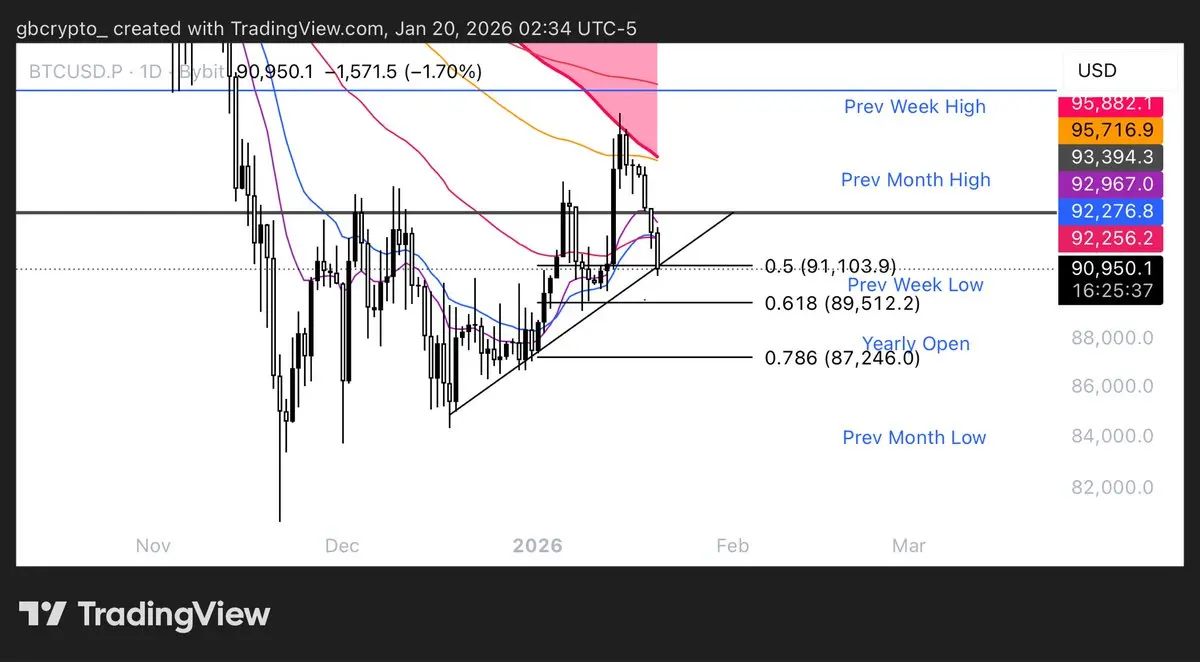

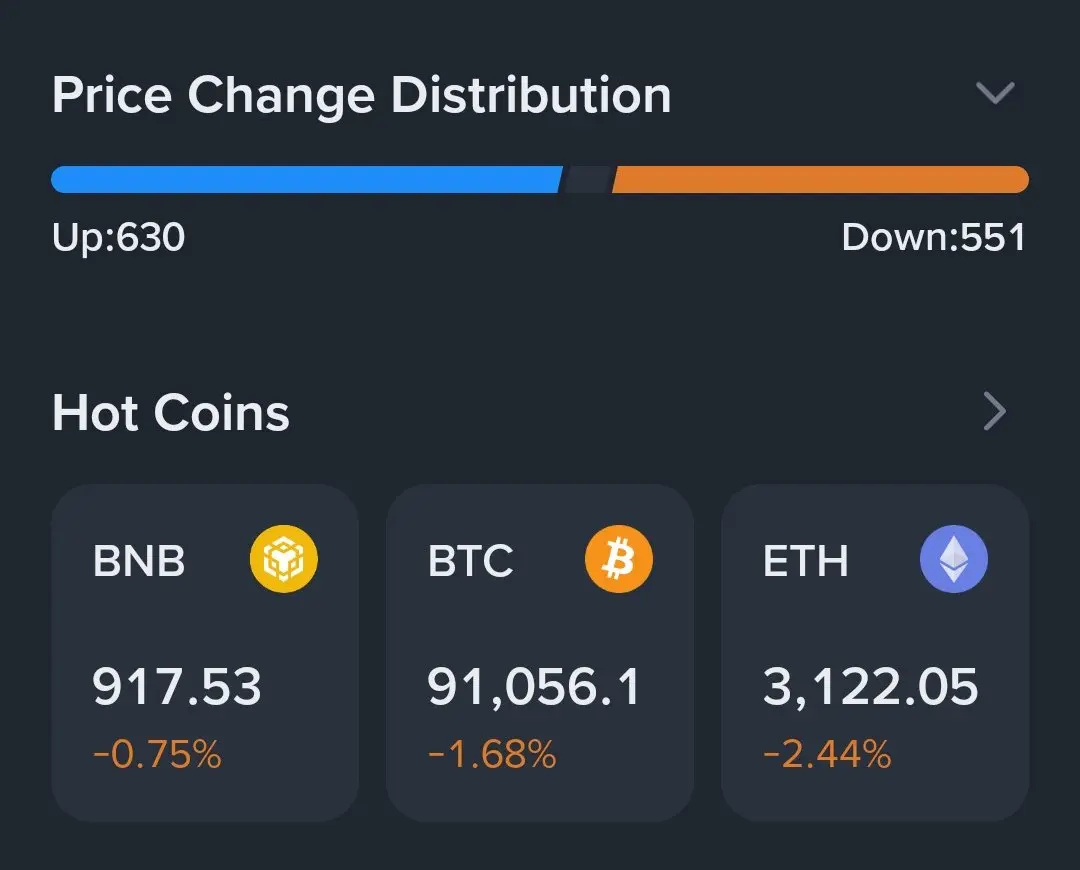

买入理财 💎粉丝朋友实盘空单止盈离场,粉丝朋友根据思路布局空单,一个星期翻个半舱问题不大,91563进场,90755出场,砍下800,4000油落袋,市场是灵活的,想盈利,就得学会思考,抱紧老郭,过个肥年#参与GateTradFi赢黄金 #欧美关税风波冲击市场 #GateLaunchpadIMU

- 赞赏

- 点赞

- 评论

- 转发

- 分享

m

币世界

创建人@币安心

上市进度

0.00%

市值:

$3468.96

创建我的代币

ETF新代币交易大赛火热开启!

交易XAU & XAG杠杆代币,签到分享30,000 USDT!

📅 活动时间:2026年1月20日07:00 – 2026年1月30日07:00 (UTC)

✅ 每日最高可赚取700 USDT

✅ 所有参与者奖励20,000 USDT

✅ 邀请好友赢取最高500 USDT神秘宝箱

👉 立即加入:https://www.gate.com/campaigns/3882

公告链接:https://www.gate.com/announcements/article/49343

交易XAU & XAG杠杆代币,签到分享30,000 USDT!

📅 活动时间:2026年1月20日07:00 – 2026年1月30日07:00 (UTC)

✅ 每日最高可赚取700 USDT

✅ 所有参与者奖励20,000 USDT

✅ 邀请好友赢取最高500 USDT神秘宝箱

👉 立即加入:https://www.gate.com/campaigns/3882

公告链接:https://www.gate.com/announcements/article/49343

查看原文

- 赞赏

- 2

- 6

- 转发

- 分享

CryptoVortex :

:

新年快乐!🤑查看更多

上Gate App抢黄金,每10分钟送1g !

- 赞赏

- 点赞

- 评论

- 转发

- 分享

$GAT 先明确核心结论:GAT(图注意力网络)是GNN的重要分支,核心是用注意力机制动态分配邻居权重,解决GCN等固定权重的局限,兼顾自适应、可并行与可解释,适合异质/动态图与节点分类等任务,但存在计算与过拟合风险。以下从原理、优劣势、应用与实践要点展开。

一、核心原理(一句话+流程)

- 一句话:节点学会“更关注哪些邻居”,用注意力权重加权聚合邻居信息,得到更精准的节点表示。

- 计算流程:

1. 线性变换:节点特征通过权重矩阵投影到新空间

2. 注意力计算:用自注意力算邻居间相关分数,经softmax归一化

3. 加权聚合:按注意力权重聚合邻居特征,加自环保留自身信息

4. 多头增强:中间层拼接多头输出扩展维度,输出层取均值提升稳定性

二、核心优势(对比GCN)

- 自适应加权:无需依赖图结构,数据驱动学权重,更贴合复杂关系。

- 高效并行:邻居权重可独立计算,不依赖全局邻接矩阵,适配大规模与动态图。

- 可解释性强:注意力权重可可视化,便于分析关键连接与决策依据。

- 归纳能力好:能处理训练时未见过的节点与结构,泛化性更优。

三、局限与风险

- 计算成本高:随邻居数增多而上升,处理超大规模图需采样优化。

- 过拟合风险:多头注意力参数多,易在小样本上学习到噪声模式。

- 边信息利用弱:原生GAT较少直接建模边特征,适配异质图需扩展(如HAN)。

-

一、核心原理(一句话+流程)

- 一句话:节点学会“更关注哪些邻居”,用注意力权重加权聚合邻居信息,得到更精准的节点表示。

- 计算流程:

1. 线性变换:节点特征通过权重矩阵投影到新空间

2. 注意力计算:用自注意力算邻居间相关分数,经softmax归一化

3. 加权聚合:按注意力权重聚合邻居特征,加自环保留自身信息

4. 多头增强:中间层拼接多头输出扩展维度,输出层取均值提升稳定性

二、核心优势(对比GCN)

- 自适应加权:无需依赖图结构,数据驱动学权重,更贴合复杂关系。

- 高效并行:邻居权重可独立计算,不依赖全局邻接矩阵,适配大规模与动态图。

- 可解释性强:注意力权重可可视化,便于分析关键连接与决策依据。

- 归纳能力好:能处理训练时未见过的节点与结构,泛化性更优。

三、局限与风险

- 计算成本高:随邻居数增多而上升,处理超大规模图需采样优化。

- 过拟合风险:多头注意力参数多,易在小样本上学习到噪声模式。

- 边信息利用弱:原生GAT较少直接建模边特征,适配异质图需扩展(如HAN)。

-

GAT-12.67%

- 赞赏

- 点赞

- 评论

- 转发

- 分享

我的Gate 2025年终总结来了!看看我今年的表现。

点击链接查看你的专属#2025GateYearEndSummary 并领取20 USDT仓位券。https://www.gate.com/competition/your-year-in-review-2025?ref=VVJDAW9YBA&ref_type=126&shareUid=VFZGV11cAAsO0O0O

查看原文点击链接查看你的专属#2025GateYearEndSummary 并领取20 USDT仓位券。https://www.gate.com/competition/your-year-in-review-2025?ref=VVJDAW9YBA&ref_type=126&shareUid=VFZGV11cAAsO0O0O

- 赞赏

- 点赞

- 评论

- 转发

- 分享

- 赞赏

- 点赞

- 1

- 转发

- 分享

A周婉盈 :

:

老司机带带我 📈- 赞赏

- 点赞

- 评论

- 转发

- 分享

昨天下播说了3215做空

- 赞赏

- 点赞

- 评论

- 转发

- 分享

逍遥仙宗

逍遥仙宗

创建人@GateUser-3145cf0e

上市进度

0.08%

市值:

$3510.45

创建我的代币

- 赞赏

- 点赞

- 评论

- 转发

- 分享

短线交易 精准快

- 赞赏

- 点赞

- 评论

- 转发

- 分享

今天我知道Nikita正在调节旋钮

查看原文

- 赞赏

- 点赞

- 评论

- 转发

- 分享

- 赞赏

- 点赞

- 评论

- 转发

- 分享

- 赞赏

- 点赞

- 评论

- 转发

- 分享

加载更多

加入 4000万 人汇聚的头部社区

⚡️ 与 4000万 人一起参与加密货币热潮讨论

💬 与喜爱的头部博主互动

👍 查看感兴趣的内容

热门话题

查看更多286 热度

3.04万 热度

4.77万 热度

9435 热度

7605 热度

快讯

查看更多置顶

Gate 广场创作者新春激励正式开启,发帖解锁 $60,000 豪华奖池

如何参与:

报名活动表单:https://www.gate.com/questionnaire/7315

使用广场任意发帖小工具,搭配文字发布内容即可

丰厚奖励一览:

发帖即可可瓜分 $25,000 奖池

10 位幸运用户:获得 1 GT + Gate 鸭舌帽

Top 发帖奖励:发帖与互动越多,排名越高,赢取 Gate 新年周边、Gate 双肩包等好礼

新手专属福利:首帖即得 $50 奖励,继续发帖还能瓜分 $10,000 新手奖池

活动时间:2026 年 1 月 8 日 16:00 – 1 月 26 日 24:00(UTC+8)

详情:https://www.gate.com/announcements/article/49112来Gate广场发帖分享你的GateAI 使用感受,赢丰厚奖励!

🎁 精选10 位幸运用户,每人奖励 $10 仓位体验券!

📌 如何参与?

1️⃣ 关注 Gate 广场_Official

2️⃣ 在广场发帖,带上话题 #我的GateAI使用体验,帖文需附上使用GateAI页面的截图

3️⃣ 创作内容表达使用感受、建议等不限

3️⃣ 帖子内容 不少于 30 字,且仅带本活动话题标签

GateAI上线详情:https://www.gate.com/announcements/article/49070

活动截止时间:2026/01/15 18:00(UTC+8)

快来广场分享你的 GateAI 使用感受吧 🚀每天看行情、刷大佬观点,却不发声?你的观点可能比你想的更有价值!

广场新人 & 回归福利进行中!首次发帖或久违回归,直接送你奖励!

每月 $20,000 奖金等你瓜分!

在广场带 #我在广场发首帖 发布首帖或回归帖即可领取 $50 仓位体验券

月度发帖王和互动王还将各获额外 50U 奖励

你的加密观点可能启发无数人,开始创作之旅吧!

👉️ https://www.gate.com/postGate 广场「创作者认证激励计划」优质创作者持续招募中!

立即加入,发布优质内容,参与活动即可瓜分月度 $10,000+ 创作奖励!

认证申请步骤:

1️⃣ 打开 App 首页底部【广场】 → 点击右上角头像进入个人主页

2️⃣ 点击头像右下角【申请认证】,提交申请等待审核

立即报名:https://www.gate.com/questionnaire/7159

豪华代币奖池、Gate 精美周边、流量曝光等超 $10,000 丰厚奖励等你拿!

活动详情:https://www.gate.com/announcements/article/47889Gate 2025 年终盛典|广场 TOP50 榜单正式公布!

冲榜关键期已开启,看直播、发帖即可获得助力值

30 助力值 = 1 票,快来为你喜爱的创作者投票

👉 https://www.gate.com/activities/community-vote-2025

iPhone 17 Pro Max、京东 E 卡、小米手环、Gate 独家周边、仓位体验券等你赢!

内容达人也欢迎积极发帖拉票,冲榜赢取荣誉与奖励!

投票截止:1 月 20 日 10:00(UTC+8)

详情:https://www.gate.com/announcements/article/48693